【sevensixTV】に第145弾の動画を配信しました。

00:30 NVIDIA×ルネサス:800V給電とGaN半導体

01:25 次世代通信IOWN:海外データセンター接続実証

02:30 TSMC:チップ直接冷却「IMC-Si」技術

03:33 光電融合と日本の巻き返し(産総研・NTT)

04:46 GPUを“持たずに使う”時代:大阪大学×NEC

05:47 日米連携:AIデータセンターの国家戦略

06:42 核融合発電とAIデータセンターの将来電源

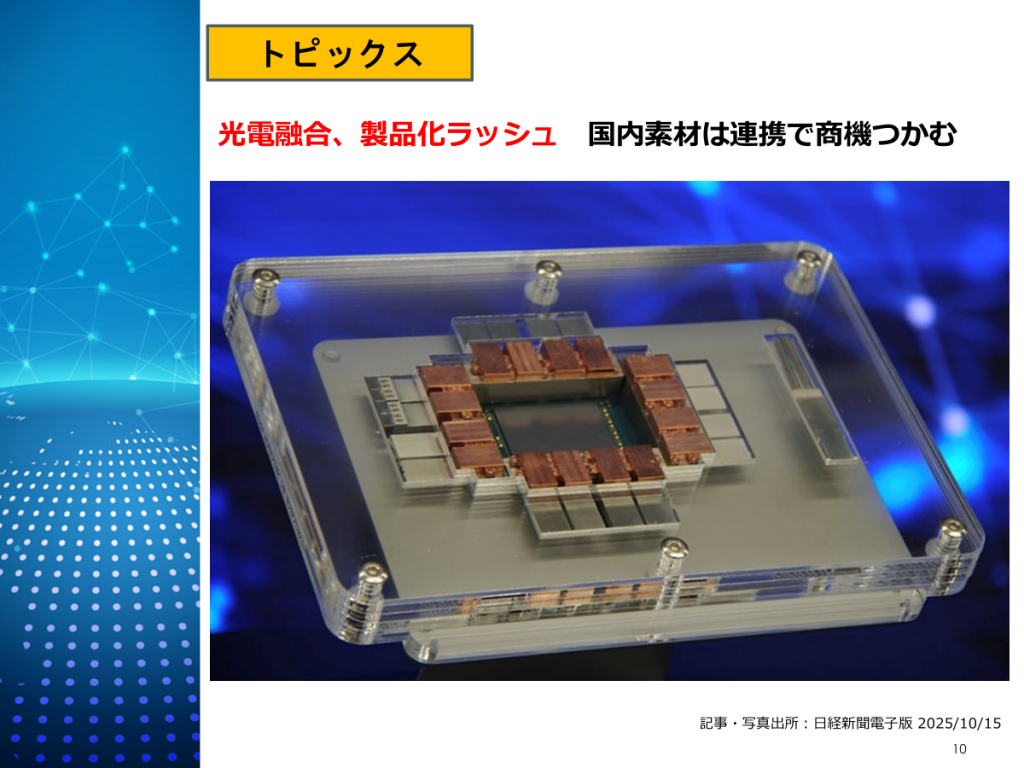

07:45 光電融合の製品化加速(CPO/IOWN)

08:49 コンテナ型データセンターの拡大

09:55 宇宙データセンター構想(SpaceX)

10:58 まとめ

AIデータセンターを取り巻く最新動向を解説する「時事ネタ企画」第11回。

今回は 2025年10月15日〜11月14日 に公開されたニュースの中から、 電力・冷却・通信・半導体・国家戦略まで、注目すべき データセンター関連ニュース10選を解説します。

AIの急拡大により、データセンターは 「計算性能」から「電力効率・冷却・通信」へと競争軸が大きく変化しています。

本動画では、

・800V給電やGaN半導体

・光電融合(IOWN / CPO)

・チップ直接冷却 ・GPUのオンデマンド利用

・コンテナ型データセンター

・核融合発電

・宇宙データセンター構想 など、AI時代のインフラ戦略を体系的に解説します。 データセンターの未来を俯瞰したい方、 AI・半導体・通信・エネルギー分野に関心のある方は、 ぜひ最後までご覧ください。

今回の記事10選

00:30 NVIDIA×ルネサス:800V給電とGaN半導体

まずは、AIデータセンターの電力効率を左右する重要なニュースです。

ルネサスエレクトロニクスが、NVIDIAと協力し、AIデータセンター向けの新しい給電システム開発に参加すると発表しました。

背景にあるのは、AIの急拡大によるデータセンターの消費電力問題です。従来のデータセンターでは、400〜500ボルトで給電するのが一般的でしたが、NVIDIAは800ボルトの高電圧給電により、送電ロスを減らし、省電力化を狙っています。

ルネサスは、この取り組みにおいて、高効率な電力変換を実現するパワー半導体を提供します。特に注目なのが、窒化ガリウム、いわゆるGaN(ガン)を使った半導体です。複数のGaN半導体を組み合わせることで、800ボルト給電に対応し、電圧変換効率は最大98%に達します。

すでにインフィニオンやSTマイクロ、ロームなども参加する中、ルネサスはこの協業を通じて、AIデータセンター向け電源分野での存在感を高め、拡大するAI需要を取り込みたい考えです。

AI時代のデータセンターでは、演算性能だけでなく、電力効率が競争力の鍵になっています。

01:25 次世代通信IOWN:海外データセンター接続実証

続いては、海外データセンターを結ぶ次世代通信に関するニュースです。

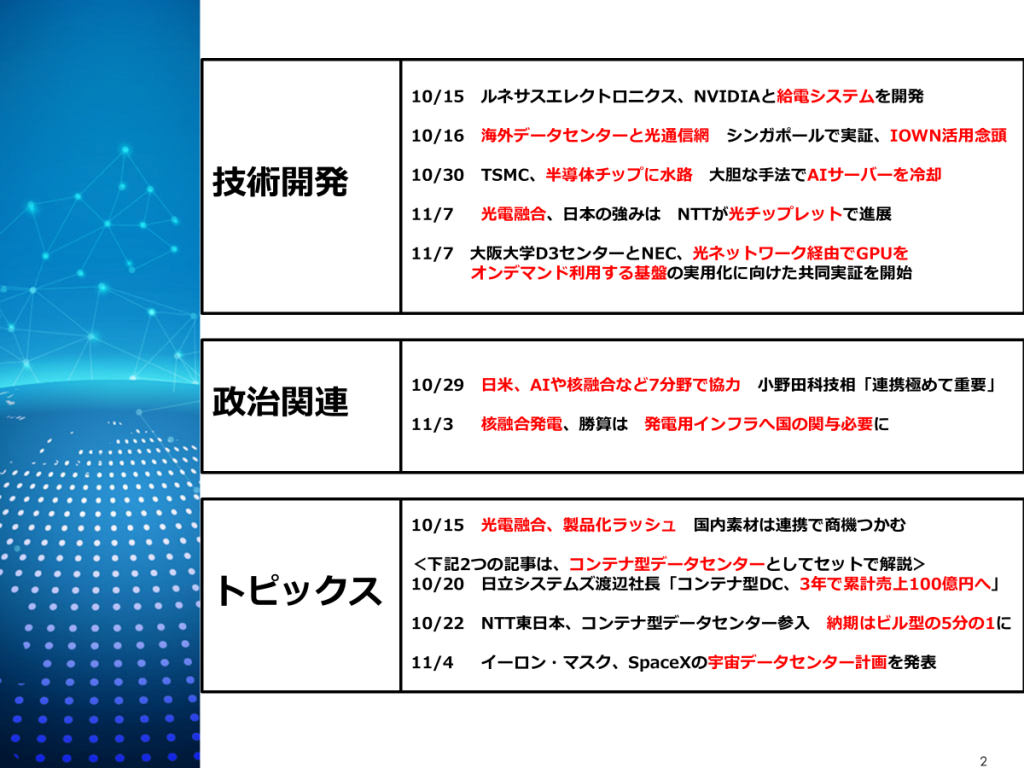

総務省は、2026年にもシンガポールで、高速な光通信技術を使った大規模実証事業を行う方針を示しました。狙いは、国境を越えてデータセンター同士を結ぶ通信網の高度化です。

実証の中心となるのが、NTTが進める次世代通信基盤『IOWN』です。これは、従来の電気信号処理を光に置き換える「光電融合技術」を使い、低消費電力で、超高速・低遅延の通信を実現します。

シンガポールを拠点に、現地のデータセンターと、日本やインドのデータセンターを接続し、距離が離れても性能を維持できるかを検証します。生成AIの普及で、データセンターの電力消費が急増する中、通信部分の省電力化は大きな課題です。

金融や製薬など、わずかな通信遅延が業務に直結する分野への導入を目指し、官民合わせて100億円規模を投じます。日本の通信技術を海外データセンター市場に広げる足がかりにする狙いです。

AI時代のデータセンターは、計算能力だけでなく、国境を越える通信効率も競争力になります。

02:30 TSMC:チップ直接冷却「IMC-Si」技術

TSMCが大胆な手法でAIデータセンターの“冷却限界”を押し広げるニュースです。

TSMCが、AIサーバー向け半導体の冷却性能を大幅に高めるため、半導体チップそのものに“水路”を作るという大胆な手法を発表しました。

背景にあるのは、生成AIの普及によるGPUの発熱量の急増です。NVIDIAの最新GPUでは消費電力が1000ワットを超え、従来の空冷や一般的な液冷では限界が見え始めています。データセンターでは、冷却が電力コストや設計のボトルネックになっています。

TSMCが開発する『IMC-Si』は、半導体チップ上に微細な流路を作り、 冷却液を直接流して冷やす技術です。従来必要だった熱伝導材を省くことで、冷却効率を約3割改善できます。

この技術は、AIサーバー向けに普及が進む先端パッケージ『CoWoS-R』(コワース)に組み込める点も特徴です。製造工程を大きく変えずに導入でき、実用性が高いとされています。

シミュレーションでは、1パッケージあたり約3400ワットの熱を除去でき、NVIDIAの最新GPU『ブラックウェルウルトラ』にも対応可能とされます。 AI時代のデータセンターでは、半導体そのものを冷やす技術が、性能と省電力の鍵になりそうです。

03:33 光電融合と日本の巻き返し(産総研・NTT)

続いては、AIデータセンターの電力問題を左右する『光電融合』で、日本がどこまで巻き返せるのか、というテーマです。

生成AIの普及により、データセンターではサーバー内部やサーバー間通信の消費電力が急増しています。その解決策として注目されているのが、電気配線の一部を光に置き換える光電融合技術です。

現在は、NVIDIAなど米半導体大手が『CPO』と呼ばれる光電融合技術をリードしていますが、このままでは日本の強みが生かせないという危機感があります。そこで産総研は、2025年に光電融合研究センターを設立し、国内企業や研究機関を束ねて技術開発を加速させています。

その中で注目されるのが、NTTの取り組みです。NTTは次世代通信基盤『IOWN』の中核として、GPUのすぐ隣に配置できる『光チップレット』を開発しています。これにより電気配線を極限まで短くし、通信の低遅延・低消費電力化を実現します。

実証では、64Gbpsの通信で、1ビットあたり0.26ピコジュールという非常に低いエネルギーでの光伝送に成功しました。

AIデータセンターの競争は、演算性能だけでなく、通信と電力効率をどこまで下げられるかが勝負になりつつあります。光電融合は、日本が再び存在感を示すための重要な切り札です。

04:46 GPUを“持たずに使う”時代:大阪大学×NEC

技術関連の最後は、GPUを“持たずに使う”時代を見据えた、データセンター型AI基盤のニュースです。

大阪大学D3センターとNECは、光ネットワークを介して、遠隔のGPUをオンデマンドで利用できるAI処理基盤の共同実証を開始しました。

ポイントは、GPUを各研究室に分散配置するのではなく、データセンターに集約し、必要なときだけ使うという考え方です。実証では、キャンパス内のデータセンターに設置したNVIDIAの最新GPUを、離れた建物にある計算サーバーから、あたかも同一マシンのように利用します。

この仕組みを支えるのが、NECの『ExpEther』(エクスプレスイーサ)技術です。通常はサーバー内部で使われるPCI Express通信を、100Gbpsの光イーサネットで延伸し、CPUとGPUを自由に接続・切り離しできるようにします。

これにより、高価なGPUを共通のリソースプールとして一元管理でき、データセンター全体でGPUの稼働率を高められます。設備投資の最適化と電力効率の改善にもつながります。

AIデータセンターの次の姿は、計算資源を“所有する”のではなく、“必要な分だけ使う”方向へ進みつつあります。

05:47 日米連携:AIデータセンターの国家戦略

政治関連からは、AIデータセンターを巡る“国家レベルの連携”に関するニュースです。 日米両政府は、人工知能や次世代通信など7つの先端分野で協力することで合意しました。その中でも注目されるのが、AIを支えるデータセンターやスーパーコンピューターといった基盤インフラの海外展開です。

両国は、AIインフラを新興国へ輸出する取り組みを進める方針で、単なるソフトウェアではなく、データセンターそのものを含めたパッケージでの展開を視野に入れています。背景には、AI分野で影響力を強める中国の存在があります。

協力分野には、AIに加え、6Gなどの次世代通信規格も含まれており、これはデータセンター同士を結ぶ高速・低遅延ネットワークの標準づくりにも直結します。

日米が連携することで、AI計算基盤、通信インフラ、そして運用ルールまでを一体で海外に広げる狙いです。

AIデータセンターは、もはや企業競争だけでなく、国家戦略の一部になりつつあります。

06:42 核融合発電とAIデータセンターの将来電源

政治関連2つめは、AIデータセンターの将来電源として注目される『核融合発電』の話題です。

生成AIの普及やデータセンター建設の加速により、電力需要は今後も大きく増えていきます。一方で、脱炭素とエネルギー安全保障も同時に達成しなければなりません。

再生可能エネルギーは重要ですが、出力が不安定で、蓄電池が不可欠です。その蓄電池は中国依存が高く、コストや安全保障の課題があります。天然ガスも期待されていますが、 高効率ガスタービンの供給不足で限界が見えています。

こうした中、原子力より安全性が高いとされる核融合発電への期待が高まっています。先行する米国の企業では、2027年にも実証炉の運転データ取得が計画され、成功すれば2030年代の実用化が現実味を帯びます。

データセンターにとって核融合は、24時間安定して大量の電力を、脱炭素で供給できる理想的な電源です。ただし、日本では、実際に発電事業を担う主体や、 送電・発電インフラ整備への国の関与が不透明という課題があります。

AI時代の電力確保には、核融合を含めた“次世代ベースロード電源”の議論が避けられません。

07:45 光電融合の製品化加速(CPO/IOWN)

AIデータセンターの電力構造を変える『光電融合』が、いよいよ製品化フェーズに入るというニュースです。2026年を境に、電気配線の一部を光配線に置き換える光電融合技術の製品化が一気に加速します。

背景にあるのは、AIデータセンターの消費電力問題です。従来は、サーバーやスイッチ基板上を電気配線でつないでいましたが、これが電力と発熱の大きな要因でした。そこで注目されているのが、半導体チップと同じパッケージ内に光学部品を組み込む『CPO』と呼ばれる技術です。

NVIDIAやブロードコムは、このCPOを使うことで、データ伝送に伴う消費電力を従来の3分の1以下にできるとしています。まずは、データセンターの中枢を担うスイッチICから導入が進み、2026年には製品化ラッシュを迎える見込みです。

日本勢では、NTTが次世代通信基盤『IOWN』向けに光電融合技術を展開し、巻き返しを狙っています。同時に、日本の部素材メーカーにとっては、標準を押さえられるかどうかが大きな商機になります。

08:49 コンテナ型データセンターの拡大

AI時代のデータセンターの“現実解”として存在感を増す、コンテナ型データセンターに関するニュースを2本まとめてご紹介します。

生成AIの普及で、GPUサーバーを大量に使うデータセンター需要が急増しています。ただ、従来のビル型データセンターは建設に年数がかかり、完成時には仕様が陳腐化するリスクがあります。そこで注目されているのが、短期間で設置でき、仕様変更にも柔軟なコンテナ型データセンターです。

日立システムズは、GPU向けの電源や冷却を強化した新型コンテナ型データセンターを投入し、2027年度までに累計売上100億円を目指しています。高発熱のGPUに対応するため、水冷や液浸冷却といった先端冷却技術を採用し、AI処理に最適化しています。

一方、NTT東日本も本格参入を表明しました。北海道・石狩市にコンテナ型データセンターを展開し、ビル型の5分の1となる約1年で稼働させます。1基あたり2メガワットの電力容量を確保し、直接液冷方式でAIサーバーに対応。IOWNを活用し、遠隔地データセンターとの高速接続も視野に入れています。

両社に共通するのは、“すぐ作れて、後から変えられる”データセンターへのシフトです。 AIデータセンターの主戦場は、巨大建築から、柔軟で俊敏なインフラへと確実に移りつつあります。

09:55 宇宙データセンター構想(SpaceX)

地上のデータセンターの常識を覆すかもしれない、宇宙データセンターの話題です。

イーロン・マスク氏が、SpaceXとして宇宙空間にデータセンターを設置する構想を明らかにしました。

構想のベースになるのは、次世代の『スターリンクV3』衛星です。高速レーザー通信を備えたV3衛星を大規模にスケールアップすることで、将来的にデータセンターとして機能させられる可能性があるとしています。つまり、軌道上で計算と通信を行うという発想です。

これが実現すれば、地上のデータセンターが抱える電力制約や立地問題を回避できる可能性があります。マスク氏は、Starshipロケットを使えば、数年以内に軌道上へ年間100ギガワット規模の太陽光発電能力を持ち込めるとも述べています。

ただし、具体的な時期や規模は未定で、Starshipの実用化や衛星の大規模展開が前提となります。マスク氏には過去に計画が大幅に遅れた例もあり、実現性には慎重な見方も必要です。

それでも、ベゾス氏や元Google CEOのエリック・シュミット氏なども同様の構想を語っており、宇宙データセンターは“次の選択肢”として本格的に議論され始めています。

10:58 まとめ

今月の主要記事10選のまとめですが、 まず1つ目は、AIデータセンターの限界突破です。

生成AIの普及で、GPUの消費電力と発熱は、もはや従来設計では限界に来ています。 そこで起きているのが、給電・冷却・通信の総入れ替えです。 NVIDIAとルネサスは、800ボルト級の高電圧給電で電力ロスを削減。

TSMCは、半導体チップに“水路”を作り、チップを直接冷やす技術を開発。

さらに、電気配線を光に置き換える“光電融合”では、NTTや海外勢が製品化競争に突入しています。

AIデータセンターの勝負は、 計算性能ではなく、いかに電力と熱を制御できるかに移っています。

2つ目は、データセンターの使い方そのものの変化です。 大阪大学とNECは、GPUをデータセンターに集約し、必要なときだけ光ネットワーク経由で使う実証を始めました。 GPUを“持つ”のではなく、“必要な分だけ使う”発想です。

そして、建て方も変わっています。 日立システムズやNTT東日本は、コンテナ型データセンターに本格参入。 ビル型の5分の1の期間で設置ができ、AI需要に合わせて増設も可能です。 AIデータセンターは、固定資産から、モジュール型の柔軟インフラへ進化しています。

3つ目は、国家戦略と未来の話です。 日米両政府は、AI・6G・核融合などで協力を強化。 AIデータセンターは、もはや企業インフラではなく、国家インフラです。

電力面では、核融合発電が将来の“AI向け安定電源”として注目され、 さらにイーロン・マスクは、宇宙空間にデータセンターを作る構想まで語っています。 AIデータセンターは、どこで、どんな電力で動かすのかという段階に入りました。